生成AIに限らず、AIを業務に使う際、「なんとなく良さそう」「有名だから安心」といった感覚で高性能なモデル(GPT 5.2 / Gemini 3 Pro / Claude Opus 4.5 など)を選んでしまうことは少なくありません。

近年の生成AIは全体的に性能が高く、どのモデルを使っても一見それなりに動くケースも多いため、この選び方でも短期的には問題が顕在化しないことがあります。

しかし、このような選定には次のような落とし穴があります。

一方で、適切な評価を行えば、

ようになります。

その第一歩が、何を重視するかを決め、それを定量的に評価することです。本記事では、「生成AI × 2クラス分類問題」を題材に、実務でよく使われる評価指標を整理します。

ここで、「各モデルが公開しているベンチマークスコアを見れば、どのモデルが優れているか分かるのでは?」と感じる方もいるかもしれません。

確かに、ベンチマークはモデル同士を比較するうえで有用な指標です。

同一条件・同一タスクで測定されているため、モデルの“平均的な性能”や世代間の進化を把握する目的では、非常に参考になります。

一方で、ベンチマークには明確な前提があります。

それは、汎用的に設計されたタスクやデータセットを用いて評価されているという点です。

実務で扱うタスクでは、

といった条件が、業務ごとに大きく異なります。

これらは、多くの場合ベンチマークの評価条件には含まれていません。

そのため、ベンチマークスコアが高いモデルを選んだとしても、

といった状況が起こり得ます。

つまり、ベンチマークは「モデルの一般的な性能を知るための指標」であって、「自分たちの業務タスクに最適かどうかを判断するための指標」ではありません。

本記事で扱う評価指標は、こうしたベンチマークでは見えにくい部分である、「どの誤りを重視すべきか」、「どの誤りが致命的か」踏まえて客観的に評価にするためのものです。

以降では、2クラス分類というシンプルな設定を通して、実務のタスクに即した形で精度を評価するための考え方を見ていきます。

分類問題とは、入力データをあらかじめ決めたカテゴリに振り分ける問題です。特に「2クラス分類」は、2つのどちらかに分類するシンプルな形式で、実務でも非常に多く使われています。

今まで弊社で扱ってきた案件でも、次のような2クラス分類のタスクがありました。

このように、2クラス分類は多くの業務判断のベースになっています。

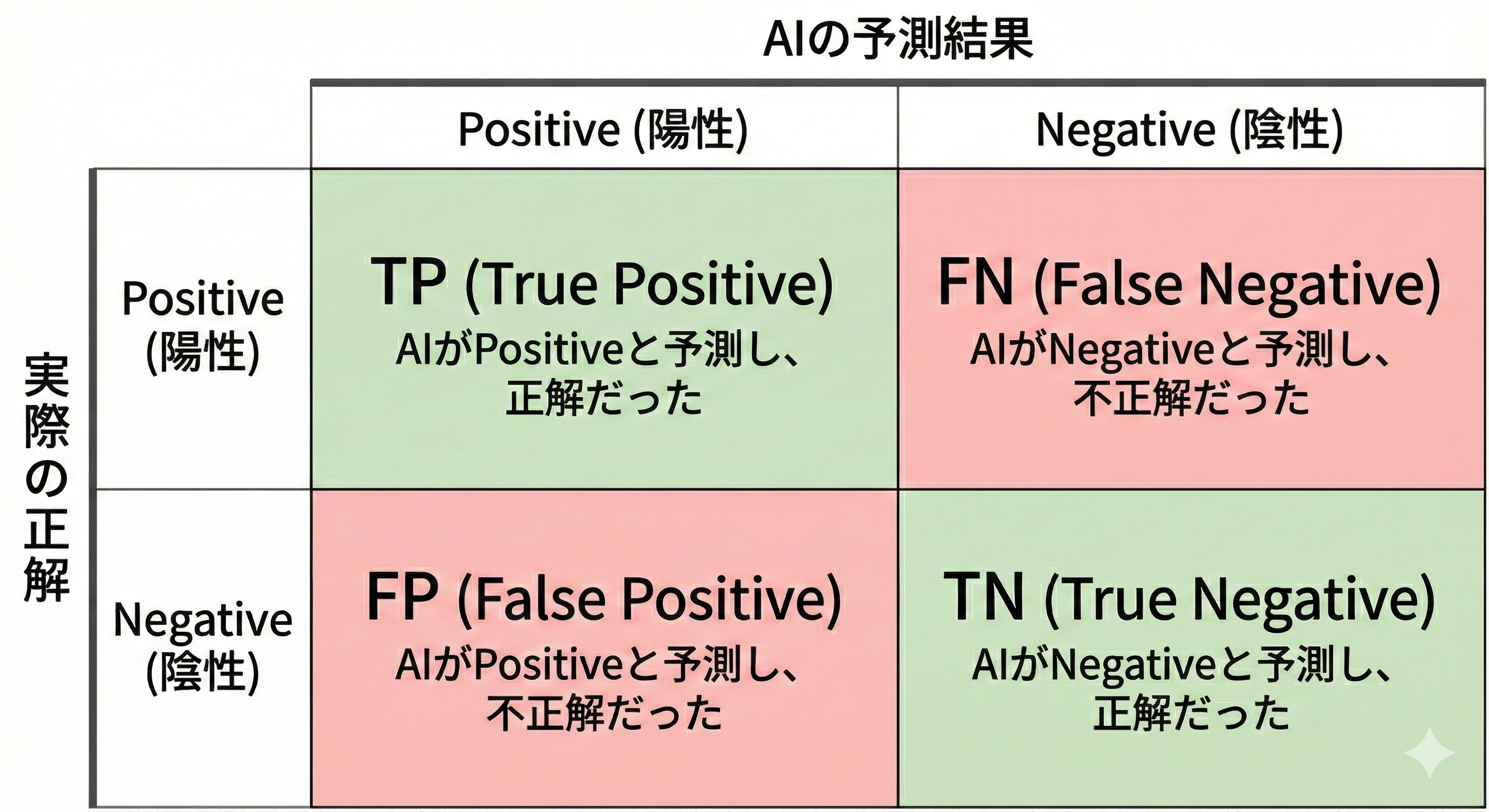

2クラス分類の評価でまず押さえるべきなのが、混同行列(Confusion Matrix)です。混同行列は、

の組み合わせを整理したものです。

ここで重要なのは、Positive / Negative はタスクごとに設計する概念だという点です。一般的には、

として設計します。

例:

この設計によって、「何を取りこぼしたくないのか」、「何を誤検知したくないのか」といった評価の軸が明確になります。

Positive / NegativeはAIの予測結果、True / Falseは正解かどうかを表します。

次から指標を見ていきますが、以下の例を使って各指標を計算していきます。

全体のうち、どれくらい正解しているかを示す指標です。

Accuracy = (TP + TN) / (TP + FP + FN + TN)

Accuracy = (80 + 90) / (80 + 20 + 10 + 90) = 0.85

直感的で分かりやすい指標ですが、クラスの偏りが大きい場合は注意が必要です。

例えば、

という極端に偏った検証用データですべてを「Negative」と予測した場合でも、

Accuracy = 999 / 1000 = 0.999

となり、一見高精度に見えてしまいます。

※ このような極端な偏りがある場合、陽性データを増やすなどが必要となりますが、ここでは無視します。

AIが「Positive」と予測したものの中で、どれくらい正しかったかを示す指標です。

Precision = TP / (TP + FP)

Precision = 80 / (80 + 20) = 0.8

下記のように、誤検知そのものが損失やコスト増加につながる場合

など、「誤ってPositiveと判定すると、後に重大な損失が出る」ケースでは、適合率が重視されます。

本来Positiveであるものを、どれだけ取りこぼさず検知(再現)できたかを示す指標です。

Recall = TP / (TP + FN)

Recall = 80 / (80 + 10) ≒ 0.889

下記のような見逃しが致命的な場合

など、「多少誤検知が増えても、見逃しは避けたい」というケースでは再現率が重視されます。

適合率と再現率のバランスを取った指標です。

F1 = 2 × (Precision × Recall) / (Precision + Recall)

F1 ≒ 2 × (0.8 × 0.889) / (0.8 + 0.889) ≒ 0.842

タスクによっては、適合率も再現率もどちらも重要なケースが出てきます。

ですが、これらの値は基本的にトレードオフとしまうため、両指標のバランスを見て決定することも多いです。

そのようなときに用いることができる指標が、F1スコアです。

評価指標を使って検証した結果、

「思ったより精度が出ない」ということは珍しくありません。

その場合、すぐに「このモデルはダメだ」、「AIは使えない」と結論づけるのではなく、タスク設計を見直すことが有効なケースも多くあります。

例えば、

といった点を見直します。例えば

といった形で、AIが判断しやすいタスクにすることで精度が大きく改善することがあります。

タスクをシンプルにする過程で、

といった作業が必要になることもあります。このとき重要なのは、その作業コストが業務上許容できるかを冷静に判断することです。

場合によっては、

という結論になることも、十分にあり得ます。

評価指標は、AIを採用するかどうかを判断するための材料でもあります。

本記事では、生成AIを用いた2クラス分類タスクを題材に、混同行列と代表的な評価指標について整理しました。

生成AIは一見すると高精度に見えることが多いものの、評価指標を用いずに判断するとオーバースペックなモデルを選んでしまったり、逆にタスクに対して能力不足のモデルを使ってしまうことがあります。

正解率、適合率、再現率といった指標を使って定量的に評価することで、モデルの特性やタスクとの相性を客観的に把握できるようになります。

また、評価の過程で「そもそもこのタスクはAIに向いていない」という判断に至ることもあります。

重要なのは、単に精度の高いモデルを選ぶことではなく、業務上どの誤りが許容でき、どの誤りが致命的なのかを明確にしたうえで、適切な評価指標を選ぶことです。

本記事が、「とりあえず最新モデル」から一歩進んだ、測って選ぶAI活用の参考になれば幸いです。

Tech Funでは、お客様のフェーズに合わせ、生成AI活用に向けた支援を3つのパックでご提供しています。

生成AIに限らず、Web・業務システム開発やインフラ設計など、技術領域を問わずご相談を承っています。「何から始めれば良いか分からない」という段階でも構いませんので、ぜひお気軽にお問い合わせください。